文章轉載自《機器之心》

當俄羅斯首個 AI 人形機器人“艾多爾”伴著電影《洛奇》的主題曲蹣跚登場時,所有人都以為某個高光時刻即將來臨。沒想到,“帥不過三秒”——

向觀眾揮手后,它迅速失去平衡、倒地抽搐,被工作人員匆忙拖走。

近期翻車的機器人可不止這一家。9 月,特斯拉 Optimus 因反應遲緩被吐槽;1X 預售款的“驚艷演示”因系遠程遙控,被輿論diss 到起飛。

業內人士對此并不意外。很多演示高度依賴人工操控,大量機器人連“站穩完成操作”都難,在工廠里“插個 dongle、貼個膜”,堪比“登月”。

英特爾在與數十家具身智能團隊溝通過程中也發現,機器人“能跑會跳”和“能在產線干活”之間,還存在巨大鴻溝。

到底是什么原因阻擋它們踏入生產一線呢?

困在算力平臺里的具身智能

11 月 19 日,重慶·2025 英特爾技術創新與產業生態大會的圓桌現場,訓練數據、應用、“大腦/小腦分家”的架構問題都被擺上臺面。但有一個答案被反復提及,算力平臺正成為橫在具身智能落地面前的最大門檻之一。

目前業內已量產、相對成熟的人形機器人,大多采用“大腦 + 小腦”的架構,所謂“慢系統 + 快系統”——

“大腦”負責深思熟慮,承擔 LLM、VLM、CNN、CLIP、SAM 等對世界建模和理解的工作;

“小腦”負責“讓身體動起來”,對反應速度極度敏感,包括 3D 定位導航、機械臂控制、步態控制等,控制頻率動輒 500Hz~1000Hz。

過去機器人主要依賴傳統運控,如今動作生成模型、多模態感知與大模型推理層層疊加,算力需求呈幾何級增長。一位現場嘉賓提到,“我們用的很多其他行業廠家的芯片,達到 100 ~ 200 個 TOPS 的稀疏算力,但依然是不夠用。”而這,還只是觸及工業場景的冰山一角。

算力飆升之下,不少企業搞“拼湊”、搭“兩套班子”。

比如,Intel 酷睿(12/13 代移動處理器)跑“大腦”,NVIDIA Jetson Orin 跑“小腦”,“兩套班子”還要跨芯片通信、跨系統協同。

結果可想而知。想想“帥不過三秒”的“艾多爾”, 視覺指令傳輸存在延遲,機器人就會摔倒。目前困擾人形擾機器人的精度、效率問題,乃至端側控制器的性能瓶頸,有一部分“歸功于此”。

算力平臺不僅是技術問題,更是落地的經濟問題。

真正到后面小批量落地的人形機器人, ROI 肯定是我們第一個考慮的指標。有嘉賓直言。

制造業對 ROI 的考核最為嚴苛。

硬指標上,機器人不僅要能干活,“穩不穩定、安不安全、貴不貴、耗不耗電”都是老板們必須算清楚的賬。

軟指標上,為避免技術投資變成“一次性死資產”, 企業希望它既能迅速上線,又能隨著工廠和產線變化靈活擴展或縮減。

顯然,搞“兩套班子”硬件堆疊,滿足不了這些苛刻要求(開發成本、散熱方案,功耗、價格、部署、可擴展性等)。

現場嘉賓認為,機器人要同時利用 CPU、GPU、NPU 多種異構算力,如何將這些異構算力高效整合到一塊小體積、低功耗芯片里,還要讓它們高度協同、被開發者輕松調用,是一道極大的挑戰。

而且,隨著具身智能加速演進,算力融合、擴展和利用效率,正在成為限制行業落地的關鍵瓶頸。

“解藥”:以“單系統”達成大小腦的“融合”

需要“兩套班子”才能完成的“大腦 + 小腦”任務,如今在一套“班子”里就能搞定。這正是英特爾給出的“大小腦融合”方案——

用一顆 SoC,把智能認知與實時控制統一到同一個架構中。

這顆 SoC,就是酷睿 Ultra 處理器。它在單一封裝內集成了 CPU、英特爾銳炫? GPU 和 NPU,并讓三者協同工作,AI推理能力、高性能CPU計算與工業級實時控制,“一手”拿捏。

是不是很像重慶火鍋的九宮格?每個 IP(CPU/GPU/NPU/I/O)就像格子里的一道菜,既能選“套餐”,也能隨需求自由組合,全看機器人廠商的“口味”需求。

結果,原本必須上云的大模型推理,能直接在端側運行,響應更快,隱私性也更高,關鍵還很經濟。

酷睿 Ultra 在保持類似功耗的情況下實現了約 100 TOPS 的 AI 算力。英特爾公司副總裁兼英特爾邊緣計算事業部的總經理Dan Rodriguez在大會Keynote上說到。用戶不需要重構系統,只要升級 CPU,就能讓原有產品具備 AI 能力。

先看看內置的GPU 。

它擁有 77 TOPS 的 AI 算力,專門負責處理最重的視覺與大模型任務。這樣的性能足以支撐 7B~13B 級別 VLM 的運行,對于物體識別、路徑規劃、分揀等任務已經游刃有余。

如果開發者需要更強的 AI 火力(更大的 LVM、VLA 等模型),可以通過 Intel Arc 獨顯進行擴展。

當算力需求沖上 千 TOPS 量級,例如大模型控制全身動作、執行多模態長鏈推理,英特爾認為應進一步結合外部“云腦”或邊緣大腦來完成協同推理。

這種按需擴展的異構算力體系,成為具身智能順利邁向復雜任務的關鍵基礎。

NPU 則負責輕負載常駐任務,如持續監聽語音喚醒、動態物體檢測等長期在線的 AI 功能,保證低功耗、零感延遲的體驗。

CPU 的價值被進一步放大。

得益于英特爾在傳統機器人運控領域多年的積累,以及對底層指令和架構的深度優化,CPU 在跑傳統視覺算法、運動規劃時比過去更快、更穩。

比如,實時抖動小于 20 微秒,意味著機器人的平衡控制、復雜力控、手眼協調等對延遲極敏感的運控環節,現在都能跑在 CPU 上。

而且,CPU 內加入了專用 AI 加速指令,使其在視覺伺服等場景中,能夠分擔部分原本由 GPU 執行的 AI 推理與軌跡規劃任務。這讓算力調度更靈活、能效更優,也更符合機器人對功耗、實時性的苛刻要求。

Dan Rodriguez還提到,明年1月發布的 Panther Lake(18A 工藝)將進一步提升性能。圖形性能最高提升 50%,同等性能下功耗降低 40%,AI 加速力提升至 180 TOPS,并支持擴展溫度范圍與工業級實時性,這意味著具身智能的應用邊界將被進一步推開。

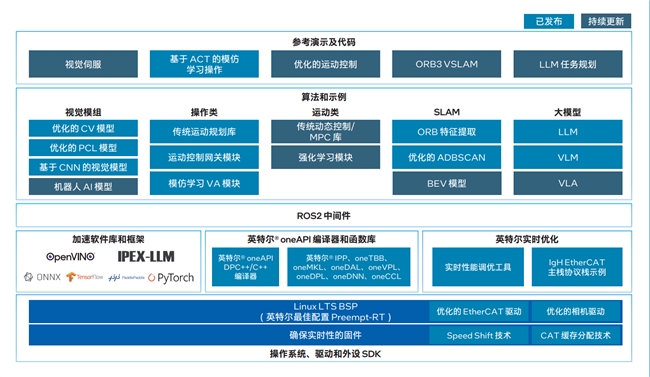

軟件棧:三管齊下,落地按下快進

算力之外,英特爾同時把軟件棧也配齊了。

從“機器人看什么、怎么學、怎么動”,一直到系統層面的調度、驅動、實時控制,英特爾提供了全棧套件,開發者不用“零幀”起步。

對于OXMs、ODMs、OEM等硬件制造商,英特爾準備的是整機級方案AI Edge Systems。操作系統、驅動、SDK、實時優化、BSP、EtherCAT 驅動,全都打包好。

比如一個已經打了 Preempt-RT 的 BSP,廠商不用再為實時性去改內核,把系統刷進去,機器人立刻具備“工業級心跳”。

系統軟件廠商處在中間層,需要把芯片的每一滴算力榨到極限,為上層應用提供最佳運行環境。英特爾給他們準備了 Open Edge Software Toolkit,里面不僅有 AI 庫和工具,更包含大量 OSV 級優化,確保在不同平臺都能跑出穩定性能。

這里簡單提幾個英特爾構建自家 AI 生態的關鍵抓手。一個是oneAPI——一條貫通 CPU/GPU/NPU 的“算力高速路”。

開發者寫一次代碼,系統自動決定跑在哪顆單元上,CPU、GPU、NPU 甚至 FPGA,全自動調度與優化。

這能讓存量設施(舊機器)和增量設施(新 AI 硬件)在同一套代碼邏輯下協同工作,打破算力“孤島”。要擴展算力?直接接上 Intel Arc 就行。

還有“黃金組合” OpenVINO + IPEX-LLM。

OpenVINO 負責 AI 推理加速,把 TensorFlow、PyTorch 等模型自動壓縮、量化、瘦身,并轉成最適合英特爾硬件執行的格式,推理在哪塊算力單元上,也自動決定并負載均衡。IPEX-LLM 則讓大模型在本地跑得更快。

兩者組合,可以適配不同年代、不同規格的邊緣設備,應對工業現場設備雜、環境復雜的現實挑戰。

針對站在最上層的行業方案開發者(ISV/SI),英特爾提供了現成的行業模板AI Suites。抓取、導航等常見技能一鍵可用,需要加大模型就直接接 LLM、VLM、VLA,還自帶參考 Demo,稍改即可落地,大幅縮短從“裸機”到“能干活的機器人”的周期。

破冰前行,開放致遠

與動輒“全家桶、一鍋端”的封閉路線不同,英特爾的“大小腦融合”選擇的是一條更開放、更有彈性的技術路徑:

同一套代碼既能跑在 CPU/GPU/NPU/FPGA 上,也能在 Intel 與 Arm 平臺間自由切換;

主流 AI 框架與模型全兼容,不鎖庫、不鎖模型;

ROS2 與各類開源算法庫也全部敞開支持。

從底層算力、網絡,到軟件棧、模型框架、應用框架,企業都可以按需自由組合。這意味著,他們不必推翻既有系統,也無需被某家供應商鎖死,而是能夠在自己的 IT/OT 基礎之上、沿著現有行業生態繼續演進,把數據和大模型真正變成生產力。

過去幾個月里,英特爾已與國內數十家具身智能廠商深入合作,已有十余家進入驗證或 POC 階段。在技術與市場都充滿不確定性的具身智能賽道里,這種開放自由的體系,正成為越來越多機器人企業愿意嘗試的路線。

更多細節,可參考英特爾具身智能白皮書。